总部位于伦敦的初创公司 Stability AI 于周三推出了一款名为 Stable Audio 的新产品,该产品利用人工智能生成定制音乐曲目和音效。

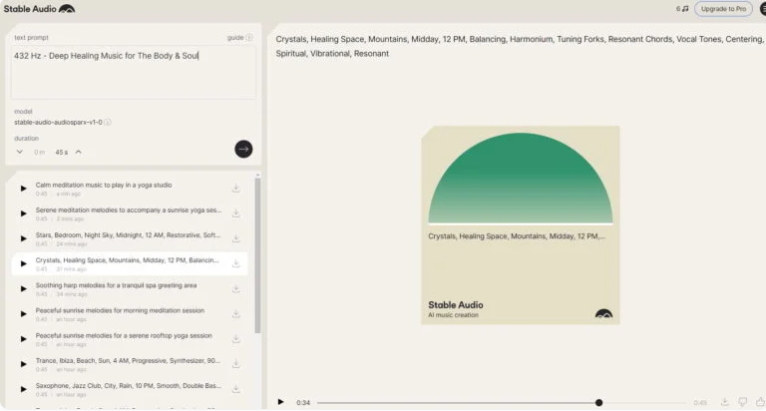

Stable Audio 使用一种基于扩散的 AI 模型,可以在几秒钟内从简单的文本输入生成定制音频文件。用户可以指定音乐风格、乐器、音调和其他特征,系统然后自动创作出相匹配的歌曲、音效或乐器声部。

Stability AI 使用输入文本进行了测试,如“后摇滚、吉他、鼓套、低音、弦乐、欢快、振奋、情绪化、流畅、原始、史诗、多愁善感、125BPM”。结果是一首快速的大气摇滚歌曲,BPM 为125。根据 Stability 的说法,这表明 Stable Audio 可以生成多种风格的歌曲,包括氛围音乐、技术音乐和电子舞曲。

与以往基于人工智能的音乐生成器不同,Stable Audio 似乎能够以长达90秒的时间生成音乐上连贯的作品,并且以44.1kHz 的专业音频质量。

生成的样本音频听起来非常真实,几乎不会让人怀疑背后没有人类作曲家。根据 Stability AI 的说法,使用 Nvidia A100GPU,95秒音频可以在不到一秒钟内生成。

这种技术有潜力在各种应用中发挥作用,特别是在电影制作和游戏开发等创意领域。通过网络浏览器可以访问,即使对人工智能不熟悉的用户也能轻松使用。

为了实现这种质量,Stability AI 对音乐库进行了培训,音乐库由 AudioSparx 提供。通过使用约80万首歌曲、音效和乐器片段,AudioSparx 与 Stability AI 合作,并承诺将音乐库的收入份额提供给初创公司 Stability Audio。作为回报,参与培训的歌曲的创作者可以通过 AudioSparx 分享 Stable Audio 的利润。

据称,在培训之前,这些创作人被问及是否愿意提供他们的歌曲。这个决定可能是对 Stability 在 Stable Diffusion 的培训素材涉及版权辩论中所面临的大规模反对的回应。

根据 Stability AI 的说法,用户可以免费将使用 Stable Audio 创建的音轨用于个人用途。商业用途需要付费订阅。该公司的目标是创意专业人士,如电影制片人或游戏开发人员,他们需要快速获得合适的背景音乐。

Stability AI 还计划发布一个基于不同数据集训练的开源音乐模型。

Stable Audio 不同于 Stable Diffusion,因为它不是开源的,不像流行的图像模型那样。然而,FAQ 中表示,将很快发布一个基于其他数据集训练的开源模型。

Stable Audio 的基础是文本到音乐的模型 Dance Diffusion,该模型是在2022年由 Harmonai 发布的,并得到了 Stability 的支持。然而,Stable Audio 是 Stability AI 音频部门从零开始开发的模型,该部门成立于2022年4月。

对音乐使用扩散模型并不是一个新的想法。然而,Stable Audio 的强大之处在于它能够以不同长度生成作品,训练过程中考虑到了这一点。

Stability AI 是这样解释底层技术的:

- Stable Audio 是一个潜在扩散模型,由几个部分组成:变分自动编码器 (VAE)、文本编码器和基于 U-net 的扩散模型。

- VAE 将立体声音频压缩为有损、抗噪声和可逆的潜在编码,从而实现更快的生成和训练。

- 新训练的 CLAP 模型的冻结文本编码器用于文本提示。

- 定时嵌入在训练期间计算并用于控制输出音频长度。

- Stable Audio 的扩散模型是基于 Moûsai 模型的9.07亿参数 U 网。

您可以通过最近推出的网络界面专门使用稳定音频。每月有20首时长不超过45秒的歌曲免费供个人使用。每月只需11.99美元,即可获得500首歌曲,播放时间长达90秒,并获得商业许可。

没有内容过滤器很容易导致抄袭

该工具还可以用来伪造流行艺术家的歌曲。到目前为止,唱片公司已经能够成功地对抗此类人工智能创作,但法律状况仍不清楚。

Stability AI 本身在接受 Techcrunch 采访时坚称,它希望负责任地使用该技术。AudioSparx 的数据库不包含流行歌曲,但许多歌曲都以知名艺术家的风格进行标记。与谷歌的 MusicLM不同,著名艺术家的名字不会被屏蔽,至少目前还没有。

Stable Audio 能否为 Stability AI 的商业模式带来回报还有待观察,该商业模式迄今为止一直处于亏损状态。无论如何,人工智能作品的令人印象深刻的质量让你刮目相看。

首页

首页

资讯

资讯

下载

下载  我的

我的